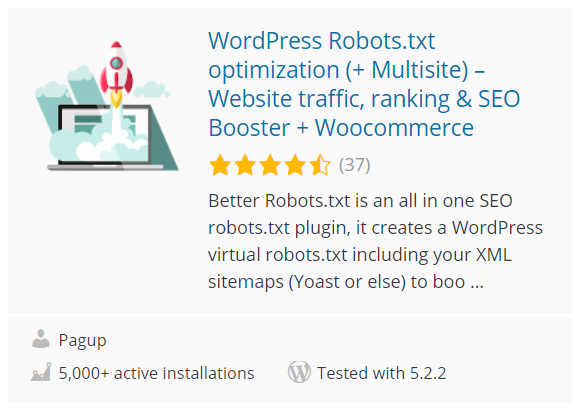

WordPress Robots.txt optimalisatie (+ Multisite) – Website traffic, ranking & SEO Booster + Woocommerce

Better Robots.txt maakt een WordPress virtuele robots.txt, helpt je een boost te geven aan je website SEO (indexeringscapaciteiten, Google ranking, etc.) en je laadprestaties – compatibel met Yoast SEO, Google Merchant, WooCommerce en Directory gebaseerde netwerk sites (MULTISITE).

Better Robots.txt is een alles-in-een SEO robots.txt plugin, het creëert een WordPress virtuele robots.txt inclusief je XML sitemaps (Yoast of andere).

Met Better Robots.txt kun je zelf bepalen welke zoekmachines je website mogen crawlen (of niet), duidelijke instructies geven over wat ze mogen doen (of niet) en een crawl-vertraging definiëren (om je hostingserver te beschermen tegen agressieve scrapers). Better Robots.txt geeft je ook volledige controle over je WordPress robots.txt content via de aangepaste instellingenbox.

Verminder de ecologische voetafdruk van je site en de productie van broeikasgassen (CO2) die inherent is aan het bestaan ervan op het web.

ONDERSTEUND IN 7 TALEN

Betere Robots.txt plugins zijn vertaald en beschikbaar in: Chinees -汉语/漢語, Engels, Frans – Français, Russisch – русский, Portugees – Portugees – Português, Spaans – Español, Duits – Deutsch.

Wist je dat….

- Het robots.txt-bestand is een eenvoudig tekstbestand dat op je webserver wordt geplaatst en dat webcrawlers (zoals Googlebot) vertelt of ze een bestand moeten openen.

- Het robots.txt-bestand bepaalt hoe spiders van zoekmachines jouw webpagina’s zien en ermee omgaan;

- Dit bestand en de bots waar ze interactie mee hebben zijn fundamentele onderdelen van hoe zoekmachines werken;

- Het eerste waar een crawler van een zoekmachine naar kijkt als hij een pagina bezoekt, is het robots.txt-bestand;

De robots.txt is een bron van SEO juice dat gewoon wacht om ontgrendeld te worden. Probeer Better Robots.txt!

Over de Pro versie (extra functies):

- Boost je content op zoekmachines met je sitemap !

Zorg ervoor dat jouw pagina’s, artikelen en producten, zelfs de meest recente, in aanmerking worden genomen door zoekmachines!

De Better Robots.txt plugin is gemaakt om te werken met de Yoast SEO plugin (waarschijnlijk de beste SEO plugin voor WordPress websites). Het zal detecteren of je momenteel Yoast SEO gebruikt en of de sitemap functie is geactiveerd. Als dat zo is, dan zal het automatisch instructies toevoegen aan het Robots.txt bestand waarin bots/crawlers gevraagd wordt om je sitemap te lezen en te controleren of je recente wijzigingen in je website heeft aangebracht (zodat zoekmachines de nieuwe content die beschikbaar is kunnen crawlen).

Als je je eigen sitemap wilt toevoegen (of als je een andere SEO plugin gebruikt), dan hoeft je alleen maar je Sitemap-URL te kopiëren en te plakken, en Better Robots.txt zal deze toevoegen aan je WordPress Robots.txt.

- Bescherm je gegevens en contennt

Blokkeer slechte bots zodat ze je website niet meer kunnen scrapen en je data kunnen doorverkopen.

De Better Robots.txt plugin helpt je de meeste populaire slechte bots te blokkeren zodat ze jouw data niet meer kunnen crawlen en scrapen.

Als het gaat om dingen die op jouw site crawlen, zijn er goede bots en slechte bots. Goede bots, zoals Google bot, crawlen jouw site om deze te indexeren voor zoekmachines. Anderen crawlen jouw site met minder goede bedoelingen zoals het verwijderen van je content (tekst, prijs, enz.) voor herpublicatie, het downloaden van hele archieven van je site of het extraheren van je afbeeldingen. Sommige bots sloopten zelfs hele websites als gevolg van het intensieve gebruik van breedband.

De Better Robots.txt plugin beschermt je website tegen spiders/scrapers die door Distil Networks als slechte bots worden bestempeld.

- Verberg & bescherm je backlinks

Voorkom dat concurrenten jouw winstgevende backlinks kunnen identificeren.

Backlinks, ook wel “inkomende links” of “inbound links” genoemd, worden aangemaakt wanneer de ene website naar de andere linkt. De link naar een externe website wordt een backlink genoemd. Backlinks zijn vooral waardevol voor SEO omdat ze een laten zien dat de ene site de andere vertrouwd. Eigenlijk zijn backlinks naar je website zijn een signaal aan zoekmachines dat anderen instaan voor jouw content.

Als veel sites een link naar dezelfde webpagina of website hebben, kunnen zoekmachines concluderen dat de content de moeite waard is om naar te linken, en dus ook de moeite waard om te laten zien op een SERP. Het verdienen van deze backlinks genereert dus een positief effect op de positie of de zichtbaarheid van een site. In de SEM industrie is het heel gebruikelijk voor specialisten om te identificeren waar deze backlinks vandaan komen (concurrenten) om zo de beste ervan te sorteren en hoogwaardige backlinks te genereren voor hun eigen klanten.

Het creëren van zeer rendabele backlinks voor een bedrijf kost veel tijd (tijd + energie + budget) en als jouw concurrenten ze zo gemakkelijk kunnen identificeren en dupliceren is dat gewoon puur verlies aan efficiëntie.

Better Robots.txt helpt je alle SEO crawlers (aHref, Majestic, Semrush) te blokkeren zodat ze jouw backlinks niet op kunnen sporen.

- Vermijd Spam Backlinks

Bots die de commentformulieren van je website invullen en je schrijven over over ‘een geweldig artikel’, ‘de informatie is geweldig’, ‘ik hoop dat je binnenkort meer over het onderwerp kunt vertellen’ of zelfs persoonlijke opmerkingen kunt geven, waaronder de naam van de auteur, zijn er legio. Spambots worden steeds intelligenter en helaas kunnen comment spamlinks je backlink profiel echt beschadigen. Better Robots.txt helpt je voorkomen dat deze comments worden geïndexeerd door zoekmachines.

- Seo tools

Tijdens het verbeteren van onze plugin hebben we snelkoppelingen toegevoegd aan 2 zeer belangrijke tools (als je bezorgd bent om je ranking in zoekmachines): Google Search Console & Bing Webmaster Tool. Als je ze nog niet gebruikt kun je ze nu jouw website indexering laten beheren terwijl je je robots.txt optimaliseert! Er werd ook een directe toegang tot een Mass ping tool toegevoegd, waardoor je jouw links op meer dan 70 zoekmachines kunt pingen.

We hebben ook 4 snelkoppelingen gemaakt met betrekking tot de beste Online SEO Tools, direct beschikbaar op Better Robots.txt SEO PRO. Zodat je, wanneer je maar wilt, nu in staat bent om de laadprestaties van je site te controleren, je SEO-score te analyseren, je huidige positie op SERPs met keywords en traffic te identificeren, en zelfs je hele website te scannen op dode links (404, 503 fouten, ….), rechtstreeks vanuit de plugin.

- Wees uniek

We dachten dat we een vleugje originaliteit konden toevoegen op Better Robots.txt door een functie toe te voegen waarmee je jow WordPress-robots.txt kunt “aanpassen” met je eigen unieke “handtekening”. De meeste grote bedrijven in de wereld hebben hun robots.txt gepersonaliseerd door spreekwoorden (https://www.yelp.com/robots.txt), slogans (https://www.youtube.com/robots.txt) of zelfs tekeningen (https://store.nike.com/robots.txt – onderaan) toe te voegen. En waarom zou jij dat ook niet doen? Daarom hebben we op de instellingenpagina een specifiek gebied ingericht waar je wat je maar wilt kunt schrijven of tekenen (echt) zonder je robots.txt-efficiëntie te beïnvloeden.

- Voorkom dat robots nutteloze WooCommerce links crawlen

We hebben een unieke functie toegevoegd die het mogelijk maakt om specifieke links (“aan winkelwagentje toevoegen”, “bestellenper”, “fllter”, winkelwagen, account, kassa, ….) te blokkeren zodat zoeksites bepaalde links niet meer kunnen crawlen. De meeste van deze links vereisen veel CPU, geheugen en bandbreedte gebruik (op hosting server) omdat ze niet cacheerbaar zijn en/of “oneindige” crawling loops creëren (terwijl ze nutteloos zijn). Het optimaliseren van je WordPress robots.txt voor WooCommerce als je een online winkel hebt maakt het mogelijk om meer rekenkracht over te hebben voor pagina’s die er echt toe doen en je laadprestaties te verbeteren.

- Vermijd crawler traps:

“Crawler traps” zijn een structureel probleem binnen een website dat ervoor zorgt dat crawlers een vrijwel oneindig aantal irrelevante URL’s vinden. In theorie kunnen crawlers vast komen te zitten in een deel van een website en nooit klaar zijn met deze irrelevante URL’s te crawlen. Better Robots.txt helpt crawler traps te voorkomen die het crawler budget schaden en dubbele content veroorzaken.

- Growth hacking tools

De snelst groeiende bedrijven zoals Amazon, Airbnb en Facebook, hebben allemaal de groei van de breakout gedreven door hun teams op één lijn te brengen met een high velocity/ leerproces. We hebben het over Growth hacking. Growth hacking is een proces van snel experimenteren met en implementeren van marketing- en promotiestrategieën die uitsluitend gericht zijn op efficiënte en snelle bedrijfsgroei. Better Robots.txt biedt een lijst van 150+ tools die online beschikbaar zijn om je groei te versnellen.

- Robots.txt Post Meta Box voor handmatige uitsluitingen

Deze Post Meta Box maakt het mogelijk om “handmatig” in te stellen of een pagina zichtbaar moet zijn (of niet) op zoekmachines door een speciale “disallow” + “noindex” regel in je WordPress robots.txt toe te voegen. Waarom is het een aanwinst voor jow ranking in de zoekmachines? Gewoon omdat sommige pagina’s niet bedoeld zijn om te worden gecrawld / geïndexeerd. Bedankt pagina’s, landingspagina’s, pagina’s met uitsluitend formulieren zijn nuttig voor bezoekers, maar niet voor crawlers, en je hebt ze niet nodig om zichtbaar te zijn op zoekmachines. Ook moeten sommige pagina’s met dynamische kalenders (voor online boeken) NOOIT toegankelijk zijn voor crawlers, omdat ze de neiging hebben om ze te vangen in oneindige crawling loops die direct van invloed zijn op je crawl-budget (en je ranking).

Zoals altijd binnenkort meer….

Better Robots.txt plugin is ingeschakeld, maar waarom kan ik geen veranderingen zien in het robots.txt bestand?

Better Robots.txt maakt een WordPress virtueel robots.txt bestand. Zorg ervoor dat je permalinks zijn ingeschakeld via Instellingen > Permalinks. Als de permalinks werken zorg er dan voor dat er geen fysieke robots.txt bestand op je server staat. Aangezien het niet over een fysiek bestand kan schrijven, moet je verbinding maken met FTP en robots.txt hernoemen of verwijderen uit de hoofdmap van je domein. Het staat meestal in /public_html/ map op cPanel hostings. Als je de hoofdmap van je domein niet kunt vinden, vraag dan je hostingprovider om hulp. Als het probleem aanhoudt na het nemen van deze maatregelen, post het dan in de ondersteuningssectie of stuur een bericht naar [email protected]

Is er een conflict met robots.txt die ik al gebruik?

Als je een fysieke robots.txt op je webhosting server hebt, dan zal deze plugin niet werken. Zoals gezegd, het creëert een WordPress virtueel robots.txt bestand. Volg de stappen in het bovenstaande antwoord als je robots.txt bestand wilt gebruiken met deze plugin.

Hoe kan ik sitemap toevoegen aan mijn WordPress robots.txt bestand?

Deze functie is toegestaan in de versie Better Robots.txt Pro, die automatisch een sitemap toevoegt in het robots.txt-bestand. Het detecteert de sitemap van de Yoast SEO plugin. Als je een andere sitemap plugin gebruikt of een handmatig gegenereerde sitemap dan kun je gewoon de sitemap URL toevoegen in het sitemap invoerveld. Als Yoast XML sitemaps ook zijn ingeschakeld dan moet je deze eerst uitschakelen door naar Yoast Algemene Instellingen > Functies te gaan en de XML Sitemapsfunctie uit te schakelen.

Waarom zou ik de robots.txt optimaliseren?

Waarom niet? Aangezien de robots.txt het allereerste bestand is dat wordt gelezen wanneer jouw website wordt geladen door een browser, waarom zouden crawlers je inhoud niet continu kunnen indexeren? Het simpele feit van het toevoegen van je Sitemap in de Robots.txt is gewoon een kwestie van gezond verstand. Waarom? Heb je jouw website op Google Search Console geplaatst, heeft jouw webmaster dit gedaan? Hoe vertel je de crawlers dat je nieuwe content beschikbaar hebt voor indexatie op je website? Als je wilt dat deze content wordt gevonden op zoekmachines (Google, Bing, …), dan moet je deze laten indexeren. Dat is precies wat deze instructie (het toevoegen van de sitemap) tot doel heeft. Nog een laatste punt. De belangrijkste reden waarom deze plugin bestaat is te wijten aan het feit dat 95% van de tijd (op basis van duizenden SEO-analyses), de robots.txt ofwel ontbreekt, leeg of verkeerd begrepen is. Stel je nu voor dat het geactiveerd en volledig functioneel was.

Hoe kan deze plugin een boost geven aan mijn website ranking?

Deze plugin verhoogt de indexeringscapaciteit van je website, wat leidt tot een betere ranking op Google. Hoe ? Nou, het idee van het creëren van deze plugin werd genomen na het doen van honderden SEO optimalisaties op bedrijfswebsites. Zoals eerder vermeld had 95% van de geanalyseerde websites geen “geoptimaliseerde” robots.txt-bestand en terwijl we deze websites optimaliseerden, realiseerden we ons dat het alleen al door het aanpassen van de content van dit bestand, deze websites “te openen” waren (op basis van dagelijkse SEMrushanalyses). Aangezien we gewend waren om in 2 stappen (perioden) te werken, genereerde deze eenvoudige aanpassing al een aanzienlijke impact op Google Ranking, en dit nog voordat we begonnen met het grondig aanpassen van de content, de site arborescentie of META Data. Hoe meer je zoekmachines helpt bij het begrijpen van je website, hoe beter je helpt bij het verkrijgen van betere resultaten op SERPs.

Hoe test en valideer je jouw robots.txt?

Terwijl je de inhoud van je robots.txt kunt bekijken door naar de robots.txt URL te navigeren, is de robots.txt Tester van de Google zoekconsole de beste manier om dit te testen en te valideren.

Log in op je Google Search Console Account. Klik op robots.txt Tester, te vinden onder Crawl opties. Klik op de knop Test.

Als alles in orde is, zal de Test-knop groen worden en het label zal veranderen in TOEGESTAAN. Als er een probleem is, wordt de lijn die een weigering veroorzaakt gemarkeerd.

Wat is een virtueel robots.txt bestand?

WordPress gebruikt standaard een virtueel robots.txt bestand. Dit betekent dat je het bestand niet direct kunt bewerken of vinden in de root van je directory.

De enige manier om de inhoud van het bestand te bekijken, is door https://www.yourdomain.com/robots.txt in je browser te typen.

De standaardwaarden van WordPress robots.txt zijn:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Wanneer je de optie “Ontmoedig zoekmachines om deze site te indexeren” inschakelt onder Zoekmachine Zichtbaarheidsinstellingen, wordt de robots.txt. de robots.txt:

User-agent: *

Disallow: /

Wat in principe alle crawlers de toegang tot de website blokkeert.

Waarom is Robots.txt belangrijk?

Er zijn 3 belangrijke redenen waarom je een robots.txt bestand zou willen gebruiken.

Blokkeer niet-openbare pagina’s: Soms heb je pagina’s op je site die je niet geïndexeerd wilt hebben. Je kunt bijvoorbeeld een staging-versie van een pagina hebben. Of een inlogpagina. Deze pagina’s moeten bestaan. Maar je wilt niet dat er willekeurige mensen op terechtkomen. Dit is een geval waarin je robots.txt zou gebruiken om deze pagina’s te blokkeren voor zoekmachine crawlers en bots.

Maximaliseer Crawl Budget: Als je moeite hebt om al je pagina’s geïndexeerd te krijgen, heb je misschien een crawl budget probleem. Door onbelangrijke pagina’s te blokkeren met robots.txt, kan Googlebot meer van je crawl budget besteden aan de pagina’s die er echt toe doen.

Voorkomt het indexeren van bronnen: Het gebruik van meta-richtlijnen kan net zo goed werken als Robots.txt om te voorkomen dat pagina’s geïndexeerd worden. Meta-richtlijnen werken dan weer niet zo goed voor multimediabronnen, zoals PDF’s en afbeeldingen. Dat is waar robots.txt om de hoek komt kijken.

Je kunt controleren hoeveel pagina’s je hebt geïndexeerd in de Google Search Console.

Als het aantal pagina’s overeenkomt met het aantal pagina’s dat je wilt indexeren hoeft je je niet bezig te houden met een Robots.txt-bestand.

Maar als dat aantal hoger is dan je had verwacht (en je ziet geïndexeerde URL’s die niet geïndexeerd moeten worden), dan is het tijd om een robots.txt-bestand voor je website te maken.

Robots.txt vs. Meta Directives

Waarom zou je robots.txt gebruiken als je pagina’s op paginaniveau kunt blokkeren met de “noindex” meta tag?

- Zoals eerder vermeld, is de noindex tag lastig te implementeren op multimediabronnen, zoals video’s en PDF’s.

- Als je duizenden pagina’s hebt die je wilt blokkeren, is het soms ook gemakkelijker om het hele gedeelte van die site te blokkeren met robots.txt in plaats van handmatig een noindex tag toe te voegen aan elke pagina.

- Er zijn ook gevallen waarin je geen crawl-budget op Google wilt verspillen door op pagina’s met de noindex tag te landen.

- Belangrijke dingen over robots.txt

- Robots.txt moet in de hoofdmap staan, d.w.z. domain.com/robots.txt.

- Elk subdomein heeft zijn eigen robots.txt nodig (sub1.domain.com, sub2.domain.com, …. ), terwijl multisites slechts één robot.txt nodig hebben (domain.com/multi1, domain.com/multi2, ….).

- Sommige crawlers kunnen robots.txt negeren.

- URL’s en het robots.txt-bestand zijn hoofdlettergevoelig.

- Crawl-vertraging wordt niet gehonoreerd door Google (omdat het zijn eigen crawl-budget heeft), maar je kunt de crawl-instellingen beheren in Google Search Console.

- Valideer je robots.txt bestand in Google Search Console en Bing Webmaster Tools.

- Blokkeer het crawlen niet om dubbele inhoud te voorkomen. Pagina’s die worden omgeleid, mogen niet worden geweigerd. Crawlers zullen niet in staat zijn om de omleiding te volgen.

- De maximale grootte voor een robots.txt bestand is 500 KB.