Une idée, originale, saugrenue certains diraient mais qui progressivement, depuis plus de 6 mois, est en train de faire son bout de chemin. Comment un simple site Web pourrait participer à lutter contre le réchauffement climatique?

Pour le comprendre, il faut se plonger dans le monde du Web, des moteurs de recherche et de leur fonctionnement. Chaque jour, de nouveaux sites Web apparaissent sur Internet contribuant à enrichir, peu importe le contenu, l’information disponible en ligne. Grâce aux moteurs de recherche, dont la mission est d’indexer le contenu en vue de le rendre accessible en ligne via de simples requêtes, tout un chacun, peu importe l’endroit où il se trouve dans le monde, peut accéder aux contenus les plus variés, sur son ordinateur ou son cellulaire. C’est la beauté des moteurs de recherche, dont Google en est le plus efficace représentant.

Toutefois, le processus d’indexation d’un site, qui, faut-il le préciser, se réalise en continu (donc tout le temps, ou presque) afin de permettre l’accessibilité de l’information publiée (incluant la plus récente), est particulièrement énergivore! Il s’agit ici, pour les robots d’exploration (crawlers – spiders) de visiter votre site Web, de lien en lien, afin de détecter la présence de nouvelles pages, de contenu, de changement permettant de les représenter le plus fidèlement possible dans les résultats de recherche (SERP). À ce titre, Google, qui est devenu en quelques années le moteur de recherche le plus utilisé dans le monde, excelle dans sa capacité à fournir les informations les plus appropriés et pertinentes selon les requêtes faites par les utilisateurs. C’est un savant mélange de technologie, d’algorithme, de serveur, de puissance, etc. qui permet à votre dernier article publié sur votre site, d’être, en quelques jours, lu, catalogué, organisé, référencé et rendu disponible en quelques clics au premier visiteur intéressé par votre sujet.

Et ce travail est titanesque. Pour vous donner une idée, Google effectue pour le compte de ses utilisateurs plus de 3.5 milliards de recherches par jour, faisant de celui-ci le principale responsable, à hauteur de 40%, de l’empreinte carbonée du Web en général. Pour vous donner un ordre de grandeur, en 2015, une étude avait établi que l’activité sur le Web, en matière de production de CO2 (relativement à l’utilisation de millions de serveurs, de systèmes de refroidissement, etc.) équivalait à la production de CO2 émanant de l’industrie de l’aviation à l’échelle planétaire.

D’ailleurs, à titre d’information, sur les quelques secondes qu’il vous aura fallu pour lire ces premières lignes, Google aura déjà émis plus de 40 tonnes de CO2 :

http://www.janavirgin.com/CO2/

Soit 500Kg de Co2 produit par seconde…

Édifiant, non ?

Même si Google est conscient de son empreinte carbone et que les fondateurs ont mis en place très tôt dans l’aménagement de leurs centres de données, des processus moins énergivores en investissant notamment dans des énergies propres et en disposant de nombreux programmes de compensation des émissions de carbone, il n’en reste pas moins que l’infrastructure de Google émet un volume considérable de CO2. Et malheureusement, en croissance à chaque année.

Mais que pouvez-vous y faire ? Après tout, vous et votre site Web, ne peuvent pas en être tenu responsables. Vous faites votre part et à priori, vous n’avez strictement rien demandé à Google même si, dans les faits, vous en dépendez considérablement (pour le trafic sur votre site).

En fait, ce que vous pourriez faire, qui pourrait impacter à l’échelle globale (si l’ensemble des utilisateurs le faisait) la production de CO2 émise par Google pour lire le Web, en « cataloguer » l’information et en permettre l’accès aux utilisateurs, serait tout simplement de simplifier le travail que Google a, via ses robots d’indexation, à exécuter lorsque ceux-ci visitent votre site Web.

Vous ne le savez peut-être pas mais votre site Web ne se limite pas aux pages que vous créez avec votre contenu, ni à ce qui est visible dans les résultats de recherche. Votre site contient une quantité astronomique de liens internes, destinés strictement à son fonctionnement, à générer des interactions entre les pages, à filtrer des résultats, à organiser le contenu, à permettre l’accès à certaines informations limitées (utiles pour le développeur mais pas pour le visiteur), etc. Et lorsque votre site est rendu disponible à l’indexation par les moteurs de recherche (donc, concrètement, quand votre site est publié), les robots d’exploration s’évertuent, systématiquement à visiter l’ensemble des liens qu’il contient afin d’identifier la présence d’information, de l’indexer et d’en faire le traitement pour le référencement. Mais, et cette partie est importante, l’exploration de votre site Web (qui, rappelons-le, s’effectue pratiquement en continu) requiert de la puissance, beaucoup d’énergie, à la fois de la part des algorithmes d’indexation (des serveurs des moteurs de recherche) mais aussi de votre propre serveur d’hébergement.

Voilà pourquoi, très tôt, dans les processus d’amélioration continue de son système d’indexation, Google, par exemple, a défini une limite au nombre de liens qu’un robot pouvait explorer en une session. Et la raison est simple. La puissance requise par les robots d’indexation pour explorer votre site impacte directement le rendement et les performances de votre site Web. Autrement dit, votre site Web, lors du processus en question, si votre hébergement est limité (ce qui est très fréquent), est plus lent à charger les pages et le contenu qu’il contient lorsqu’il est visité (le processeur et la mémoire vive étant directement impacté).

Toutefois, cette limitation, appelée « crawl-budget » n’est pas une règle générale appliquée par l’ensemble des moteurs de recherche (connus) et certainement pas par les milliers de robots « web » (exemple : « scrapers ») visitant, copiant, analysant, en continu le Web en général. De nos jours d’ailleurs, plus de 50% du trafic mondial sur le Web est le fait de … robots. Et non d’humains. Nous ne sommes donc pas seuls.

Un dernier point, et non des moindres. Il est très fréquent, au vu parfois de la taille colossale que certains sites Web peuvent avoir (boutique en ligne, etc.) que les robots d’indexation soient « bloqués » dans certaines parties d’un site. Autrement dit, les robots d’indexation se trouvent à indexer une quantité énorme de liens (parfois infinie, s’il y a des boucles), non essentiels, propres par exemple à des fonctionnalités de calendrier en ligne (ou chaque jour, mois et année sont des pages, explorables) et dont il n’est plus en mesure de « sortir », du fait notamment de sa limitation au nombre de liens qu’il peut explorer, ayant donc pour conséquence directe d’impacter l’exploration globale de votre site et finalement, l’accessibilité de vos pages importantes (articles, services, produits, …). Ce qui peut expliquer, par exemple, que même après plusieurs semaines, certains contenus, récemment publiés, ne sont toujours visibles dans les résultats de recherche (le robot d’indexation, sans instruction précise, explore l’ensemble des liens qu’il trouve, même si ceux-ci n’ont pas le moindre intérêt pour vous).

Donc, si vous pouviez indiquer précisément aux robots d’exploration, quels qu’ils soient (Google, Bing, Yahoo, Baidu, etc.) ce qu’ils peuvent explorer et ce qui n’est pas nécessaire pour votre visibilité, vous pourriez à la fois, assurer à votre site Web de meilleures performances mais SURTOUT, diminuer significativement l’énergie (et donc la consommation électrique) requise par votre serveur d’hébergement, Google et l’ensemble des autres entités d’exploration gravitant sur le Web.

Certes, à titre individuel, cette « optimisation » ne représente que peu face aux géants du Web. Mais si tout un chacun, à l’échelle mondiale, avec les centaines de millions de sites web disponibles, participait au mouvement, cela permettrait de générer un impact réel sur l’intangible qu’est le Web. Et ainsi, diminuer la consommation électrique et in fine les rejets en CO2.

Alors que faire ?

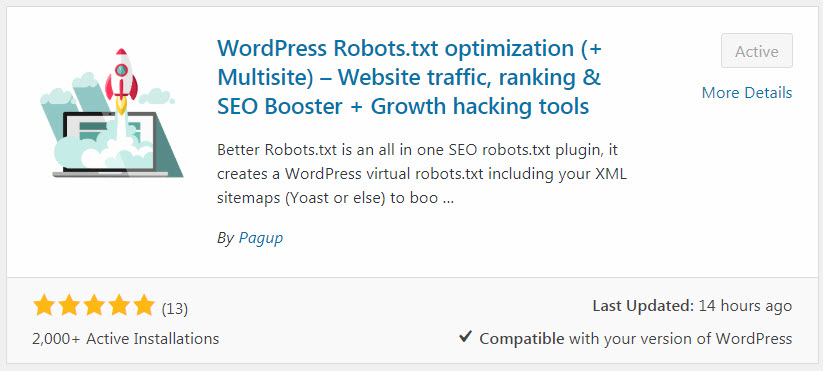

Cette mission d’optimisation, c’est celle dont s’est dotée PAGUP, une agence SEO canadienne spécialisée dans les systèmes d’optimisation pour les moteurs de recherche, en créant un « plugin » spécialement dédié à WordPress (de nos jours, près de 28% du Web est créé à partir de WordPress, 39% de toutes les boutiques en ligne sur le Web sont réalisées à partir de WooCommerce (WordPress) et WordPress représente presque 59% des parts de marché des CMS dans le monde) permettant gratuitement, très simplement et en quelques clics, l’optimisation d’un fichier, appelé le Robots.txt.

Le … quoi ?

Le « robots.txt ». Aussi incroyable que cela puisse paraître, toute cette opération d’indexation passe par l’intermédiaire d’un petit fichier que chaque site Web (peu importe celui-ci) possède à sa racine (sur le serveur d’hébergement). Ce fichier n’a qu’un seul et simple rôle, celui de communiquer avec les moteurs de recherche. En fait, il est tellement important que lorsque votre site s’affiche dans un navigateur pour un visiteur, c’est le tout premier fichier qui en est chargé. Tout comme d’ailleurs, lors de l’exploration de votre site Web par les robots d’indexation, c’est le premier fichier qui sera d’abord recherché, puis lu…pour justement savoir quoi faire de votre site.

Donc, ce fichier, tout simple, est d’une redoutable utilité. A tel point d’ailleurs, qu’une simple ligne peut totalement exclure votre site Web de l’exploration par TOUS les moteurs de recherche.

Vous souhaitez voir le contenu du vôtre? Pour cela, il vous suffit d’aller sur votre site Web et dans la barre d’adresse, d’ajouter « Robots.txt » après le « / » et vous y voilà !

C’est dans ce fichier que tout se joue.

C’est précisément par l’insertion « d’instructions » précises qu’il est possible d’informer les robots d’exploration quant à ce qu’ils peuvent lire/indexer ou pas. Le plugin en question, appelé Better Robots.txt, qui compte plus de 10k téléchargement en 6 mois, permet justement, assez facilement, de produire un robots.txt optimisé spécifiquement pour n’importe quel site WordPress en raffinant le travail d’indexation que devront réaliser les robots d’exploration de la plupart des moteurs de recherches et d’une vaste quantité d’autres entités.

Et il est gratuit …

Vous avez donc la possibilité, maintenant, de maximiser le travail d’exploration de votre site Web, de réduire l’empreinte écologique de votre site et, à votre niveau, de réduire la production de gaz à effet de serre (CO2) inhérente à son existence sur le Web.

Dans tous les cas, vous & nous y gagnons tous.