Vous venez d’acquérir Better Robots.txt PRO et vous vous demandez comment l’utiliser pour en profiter au maximum… Vous faites bien. Et cet article est là pour ça !

La première chose consiste à faire une installation en bonne et due forme.

Voici comment l’installer sur votre site Web WordPress:

Une configuration optimale de Better Robots.txt peut se faire en 4 ou 5 étapes, tout dépendant de votre niveau de connaissance du Robots.txt. Toutefois, avant même de faire votre configuration, il vous faut prendre conscience d’une chose: Better Robots.txt va créer un fichier robots.txt virtuel sur votre site (au cas où vous n’en avez pas). Si vous avez des questions à ce sujet, pensez à consulter notre FAQ.

Première étape: instructions pour les moteurs de recherche

La première tâche est simple. Il s’agit d’identifier pour quel moteur de recherche vous souhaitez obtenir une indexation de votre site Web. Il peut paraître paradoxal que ce type de requête se fasse via un fichier présent sur votre site. Toutefois, si, de mémoire, vous n’avez fait aucun listing auprès de moteurs de recherche (comme Google Search Console, Bing, etc.), le fait d’autoriser les moteurs de recherche à indexer votre contenu est une bonne chose à faire. Peut-être que ces derniers l’ont déjà fait, difficile à dire (sauf en vérifiant sur ces moteurs de recherche).

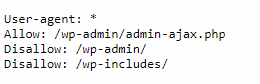

Dans ce cas ici, par défaut, ces moteurs de recherche suivront la règle de base suivante:

… Qui est vraiment la base d’instructions la plus standard pour un Robots.txt. En identifiant les moteurs de recherche qui vous concerne, vous aurez au moins l’assurance que votre site sera indexé par ces moteurs de recherche. Voici les instructions qui se rajouteront à votre Robots.txt selon les choix que vous aurez faits:

Deuxième étape: l’intégration de la sitemap

À cette étape, il peut se produire 3 scénarios.

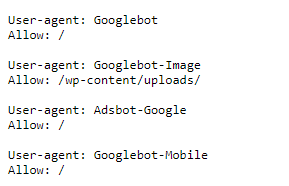

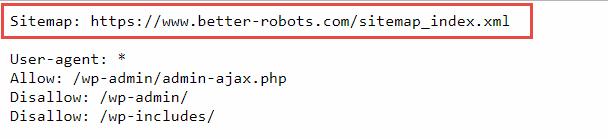

- Soit, vous utilisez d’ores et déjà le plugin YOAST SEO et vous avez bel et bien activé la fonctionnalité de sitemap. Dans ce cas, vous n’aurez rien à faire. En fait, si vous voyez très exactement le message affiché dans l’image ci-dessus (en vert), Better robots.txt aura déjà fait le travail pour vous. Concrètement, il aura détecté votre index de sitemap (contenant toutes les sitemaps) et aura rajouté son URL en première ligne du Robots.txt. Comme ceci:

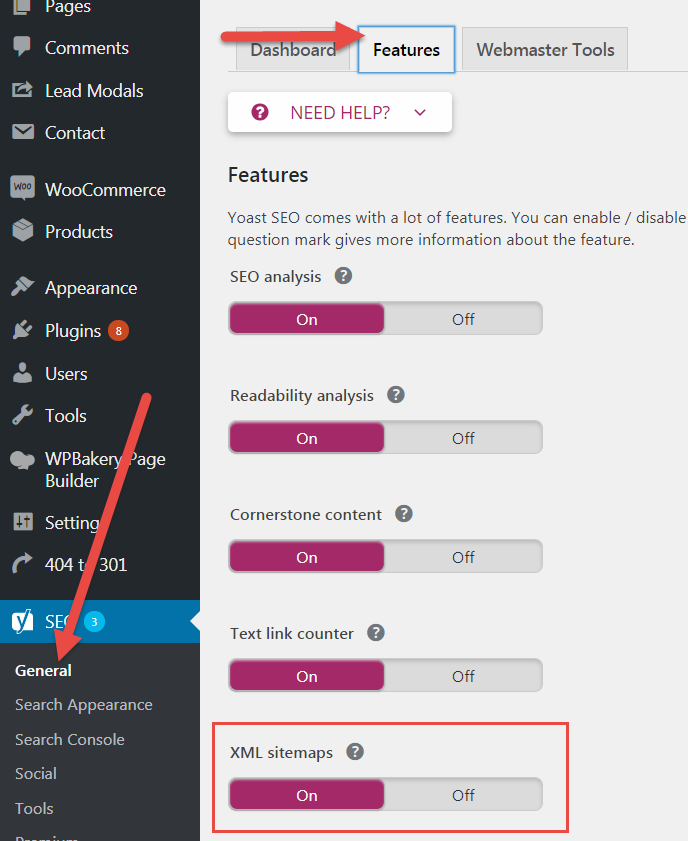

- Soit vous utilisez plugin YOAST SEO mais vous n’avez pas activé la fonctionnalité Sitemap. Dans ce cas-ci, vous verrez un message vous informant de l’activer en allant dans YOAST SEO > General (réglages généraux) > Features (fonctionnalités). Une fois fait, retournez dans les “settings” de Better Robots, et vous verrez alors le même message quand dans l’image ci-dessus. Better Robots.txt aura détecté votre index de Sitemap et l’aura rajouté dans le Robots.txt (voir ici pour YOAST):

- Soit, pour certaines raisons qui vous regardent strictement, vous n’utilisez pas le plugin YOAST SEO, et vous faites usage de toute autre plugin pour générer vos sitemaps. Dans ce cas, il vous suffira simplement d’identifier l’URL de votre sitemap et de la copier-coller dans le champ sitemap du plugin Better Robots.txt. Après sauvegarde, le plugin l’ajoutera directement dans le robots.txt.

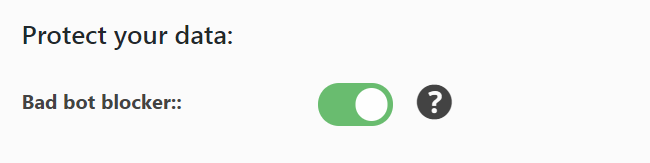

Troisième étape: bloquer les “mauvais” robots (scrapers)

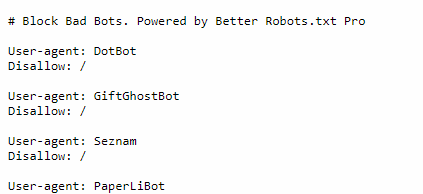

Better Robots.txt a identifié près d’une trentaine de robots considérés comme malveillant parce que copiant et republiant (ou autre) votre contenu illégalement. Ces robots sont connus pour être des “scrapers” et de nos jours, il est plus que conseillé de s’en protéger. Better robots.txt puise directement ses informations à partir d’une entité, dont la réputation n’est plus à faire dans le milieu, connue pour analyser et identifier l’ensemble des robots actifs sur le Web (Distill Network). En activant simplement le bouton “Bad bot blocker”, Better robots.txt injectera des instructions précises dans le robots.txt empêchant ces robots de lire le contenu du site.

Voici une partie des éléments qui seront ajoutés dans le robots.txt :

Avec le temps et les prochaines versions (inscrivez-vous aux mises à jour), Better robots.txt fournira une liste toujours plus détaillée de ces robots malveillants afin de vous offrir une protection optimale contre toute forme de “scrapping”. Si vous souhaitez en savoir plus à propos de ces robots malveillants, rendez-vous sur le FAQ de notre plugin où vous trouverez une liste détaillée de chacun d’entre eux ainsi qu’un lien renvoyant vers une page explicative.

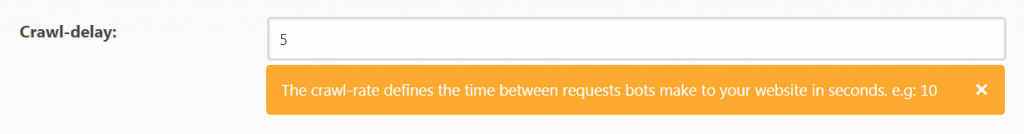

Quatrième étape: définir un crawl-delay

Par définition, la plupart des robots disposent de leurs propres règles d’indexation pour analyser et lire le contenu de votre site web (budget d’indexation), comme Google par exemple (le Crawl-delay n’était pas une fonction reconnue et suivie par les robots d’indexation de Google). Toutefois, ce n’est pas le cas pour la majorité d’entre eux. Définir un “crawl delay” général permettra dans certaines circonstances d’éviter la surcharge de vos serveurs (surtout les moins performants) par une indexation abusive de certains robots. Par défaut, nous vous recommandons la valeur “5”.

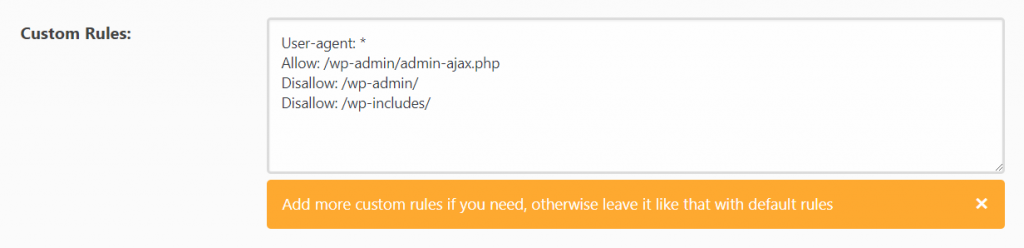

Cinquième étape: les règles personnalisées, pour les connaisseurs.

Arrivé à cette étape, si vous n’êtes pas très à l’aise avec le code en général et le contenu du robots.txt, n’allez pas plus loin. Il s’agit de personnaliser votre robots.txt en intégrant des règles plus spécifiques. Pourquoi est-ce risqué ? Tout simplement parce que le robots.txt est le seul fichier de votre site qui parle directement aux robots d’indexation. La moindre erreur, ici, à ce niveau, peut causer des résultats dramatiques et détruire votre référencement.

Toutefois, si vous êtes confortable avec le robots.txt, compte tenu que chaque site web est unique, il se peut que vous vouliez intégrer des règles supplémentaires pour éviter, au besoin, que certaines parties de votre site ne soient indexées par les moteurs de recherche. Pour ce faire, il vous suffit simplement de passer par l’éditeur créé à cet effet:

Conclusion

Après avoir terminé de configurer le plugin Better Robots.txt, nous vous conseillons de vider la « cache » de votre site Web, pour vous permettre constater directement les modifications faites dans le contenu du robots.txt. Pour y accéder, il vous suffit d’aller sur votre site Web, “https://monsite.com” et d’ajouter “/robots.txt” après l’URL, comme ceci: “https://monsite.com/robots.txt” et vous serez redirigé vers la page en question.

Ou encore d’utiliser notre outil de diagnostic :

[robotschecker]

Bon succès !